O avanço da Inteligência Artificial generativa trouxe ganhos expressivos para empresas e usuários finais. No entanto, junto com a evolução tecnológica, surgem novas ameaças. Recentemente, o Google alertou sobre tentativas de hackers de roubar a lógica interna do Gemini, seu modelo de IA generativa. O caso acende um sinal vermelho para toda a indústria de tecnologia.

Neste artigo do Tech Dicas, você vai entender o que está acontecendo, por que a “lógica” do Gemini é tão valiosa, quais os riscos envolvidos e como isso impacta empresas, desenvolvedores e usuários.

O Google Gemini é o modelo de Inteligência Artificial desenvolvido pelo Google para competir diretamente com soluções como o ChatGPT da OpenAI.

Ele é utilizado para:

-

Geração de texto

-

Análise de dados

-

Assistência em programação

-

Criação de conteúdo

-

Resolução de problemas complexos

A “lógica” do Gemini envolve algoritmos proprietários, técnicas de treinamento, pesos do modelo e estruturas internas que determinam como a IA interpreta, processa e responde às solicitações dos usuários. Trata-se de propriedade intelectual de altíssimo valor estratégico.

Confira também:

Google Cloud Lança Ferramentas para IA Generativa

Cursos Gratuitos de Inteligência Artificial na AWS

Por que hackers querem roubar a lógica do Gemini?

Roubar a lógica de um modelo como o Gemini pode permitir:

-

Replicação não autorizada da tecnologia

-

Criação de modelos concorrentes ilegais

-

Identificação de vulnerabilidades exploráveis

-

Manipulação de respostas da IA

-

Uso da estrutura para ataques cibernéticos mais sofisticados

Modelos de IA generativa exigem bilhões em investimento, infraestrutura de alto desempenho e dados massivos para treinamento. Ter acesso à arquitetura interna representa um atalho extremamente valioso e perigoso.

O risco para empresas e desenvolvedores

A tentativa de roubo da lógica do Gemini não afeta apenas o Google. O impacto pode atingir:

-

Empresas que integram APIs de IA

-

Startups que dependem de modelos generativos

-

Plataformas SaaS

-

Usuários corporativos que utilizam IA para automação

Se um modelo for comprometido, podem ocorrer:

-

Vazamento de dados

-

Engenharia reversa

-

Exploração de falhas de segurança

-

Manipulação de outputs

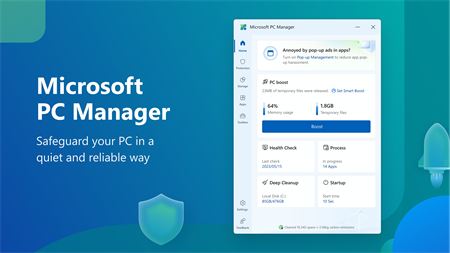

Esse cenário reforça a necessidade de práticas robustas de cibersegurança em IA, incluindo:

-

Monitoramento contínuo

-

Criptografia de ponta a ponta

-

Controle de acesso baseado em privilégios mínimos

-

Auditoria de logs

-

Testes de penetração periódicos

Aqui no Tech Dicas já abordamos a importância da segurança digital em ambientes corporativos em outros conteúdos relacionados à proteção de sistemas e boas práticas de TI um tema cada vez mais estratégico para empresas que adotam Inteligência Artificial.

A nova era dos ataques contra Inteligência Artificial

Tradicionalmente, ataques cibernéticos miravam:

-

Bancos de dados

-

Servidores

-

Sistemas financeiros

-

Infraestruturas críticas

Agora, os modelos de IA se tornam o novo alvo estratégico.

Ataques modernos podem incluir:

-

Prompt injection

-

Data poisoning

-

Model extraction

-

Exploração de APIs

O roubo de lógica é uma evolução desse cenário, pois vai além do simples acesso a dados — envolve o núcleo intelectual da tecnologia.

O impacto para o mercado de IA

Se hackers conseguirem extrair partes da arquitetura de modelos como o Gemini, isso pode:

-

Reduzir a vantagem competitiva de grandes empresas

-

Aumentar a proliferação de modelos inseguros

-

Criar versões adulteradas de IA

-

Facilitar ataques automatizados em larga escala

O mercado de IA já é altamente competitivo, e proteger a propriedade intelectual se torna um diferencial crítico.

Como usuários e empresas devem reagir?

Mesmo que o ataque seja direcionado ao Google, a lição vale para todos:

1. Revise integrações com APIs de IA

Garanta que chaves de acesso estejam protegidas e com escopos restritos.

2. Implemente governança de IA

Defina políticas claras sobre uso interno de ferramentas generativas.

3. Invista em monitoramento

Use ferramentas de SIEM e monitoramento comportamental.

4. Eduque equipes

Treinamento é essencial para reduzir riscos de engenharia social.

Segurança em IA é prioridade estratégica

Se você trabalha com tecnologia, desenvolvimento ou criação de conteúdo com IA, acompanhar esse tipo de notícia é fundamental para se manter competitivo e seguro.

O alerta do Google sobre hackers tentando roubar a lógica do Gemini mostra que entramos em uma nova fase da segurança digital. Não se trata apenas de proteger dados, mas de proteger inteligência.

A Inteligência Artificial é um ativo estratégico e, como todo ativo valioso, torna-se alvo.

Para continuar acompanhando análises sobre tecnologia, segurança da informação, inteligência artificial e tendências do mercado de TI, acompanhe o Tech Dicas e também o canal no YouTube do perfil @tidadepressao: